開発

Googleが発表最新ローカルLLM「Gemma3 」の実力とは

今回はChat-GPTなどで一般にウェブブラウザやアプリで使われているLLM(大規模言語モデル)とは別に、自分のローカル環境(サーバなど)にダウンロードして利用できるLLMについて少しお話しをします。

そもそもLLMは、簡単に誰でも使えるウェブブラウザ版と、開発者などがさまざまなサービスに利用するためのAPI版の2つが一般的な利用方法でした。

理由はAIを稼働させるには、ある程度処理能力の高いサーバや機能が必要になるためですが、最近ではセキュリティや企業の秘匿情報においてケアできるダウンロード型のLLMも急速な進化を遂げています。

その中、Googleが2025年3月に発表したばかりのモデルが、“Gemma 3”。

大幅に軽量化され、かつ、高性能を実現したことで注目されているモデルです。

このGemma3の最大の特徴は、軽量で特定タスク向けに最適化されていること。

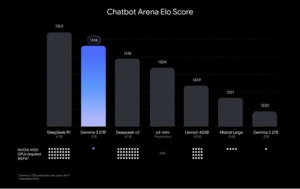

以下は、前回ご紹介したChatbot Arenaを使った性能スコア比較。

グラフ下部のドット数はGPU「NVIDIA H100」の数で、Gemma 3 27Bでも単一GPUで駆動でき、高い性能を実現していることがわかります。

また、そもそも同じGoogleのAIであるGemini(API版)と、どんな特徴の差があるのかを以下表にまとめましたので参考にしてみてください。

このように一般的に利用できるLLM以外でも、ダウンロード型LLM進化によって様々なサービスにコスト安で利用可能になってきており、益々LLMの普及が進むと考えられます。

メディアラグではこうしたAIに関するノウハウや開発経験を多数もっておりますので、

もしAIの利用を検討されていましたら、ぜひご相談ください。

お問い合わせはこちらから

CONTACT

CONTACT

03-5797-7191

03-5797-7191